日本AMDのAIに関する取り組み

日本AMDは7月10日にAI関連のソリューションを解説するワークショップを開催した。本ワークショップでは、日本AMDのAI戦略とともに、AI PCやAIワークステーション向けの製品ポートフォリオなどが紹介された。

クラウドからエッジ、クライアントまで

あらゆる場所でのAI活用を目指す

日本AMDは7月10日に、同社のAI関連のソリューションを解説するメディア向けのワークショップを開催した。本ワークショップでは、AI戦略をはじめ、ハードウェア・ソフトウェアのオープン性への取り組みや、AI PCおよびAIワークステーション向けの最新製品ポートフォリオが紹介された。AI技術の進化とともに、AMDがどのような方向性で市場にアプローチしているのか。本記事では、日本AMDのAIへの取り組みを紹介していく。

AI市場は学習から推論中心に

幅広い製品ラインアップで対応

最初に登壇した日本AMD 代表取締役社長 ジョン・ロボトム氏は、AI市場の動向について次のように語った。「現在、AIのイノベーションは急速に加速しており、市場の重心は過去の学習中心から推論中心へと移行しています。AMDの社内データによれば、AIアクセラレーター市場は今後、現在の450億ドル規模から5,000億ドル以上にまで拡大する見込みであり、特に推論分野は年平均80%を超える成長率で伸びていくと予測されています」

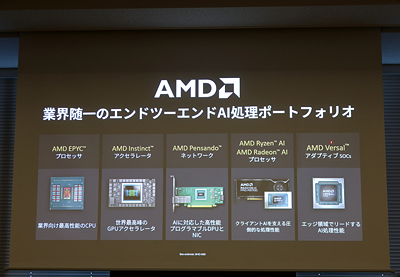

こうした推論分野の拡大に対し、AMDはすでに強みを発揮している。その背景には、用途ごとに最適な選択肢を提供できる豊富な製品群がある。AMDが提供する製品ラインアップとして、データセンター向けの高性能CPU「AMD EPYC」、データセンター向けGPUアクセラレーター「AMD Instinct」、クライアントPC向けAIプロセッサー「AMD Ryzen AI」「AMD Radeon AI」などが挙げられる。

これらの製品は、通信分野、HPC、ゲーミング、自動車産業など、日本国内でも多くの企業や顧客に採用されている。特にサーバーのCPU市場ではAMD EPYCの市場シェアが拡大しており、また世界のAI企業トップ10のうち7社がAMD Instinctを採用しているなど、AMDの製品はすでに幅広い業界で活用されているのだ。

「幅広い製品ラインアップに加え、オープンなエコシステムとフルスタックソリューションを提供していきます。そうすることで、データセンターにとどまらず、クラウドからエッジ、クライアントに至るまであらゆる場所でAIを活用できる環境を構築することを目指しています」と、ロボトム氏は同社のAI戦略について語った。

代表取締役社長

ジョン・ロボトム 氏

コマーシャル営業本部

セールスエンジニアリング担当

マネージャー

大原久樹 氏

ハードウェア・ソフトウェア双方で

オープン性を重視した設計思想を反映

続いて登壇した日本AMD コマーシャル営業本部 セールスエンジニアリング担当 マネージャー 大原久樹氏は、AMDがハードウェアやソフトウェアを設計する際に、最も重要視していることはオープン性であると語る。

まずはハードウェアにおけるオープン性から見ていこう。近年、データセンター向けの高性能GPUは消費電力が増加しており、手間がかかる大規模システムを構築する必要が出てきている。例えば、最新のGPUアクセラレーター「AMD Instinct MI355X GPU」は1,400Wの電力を必要とし、1ノードに8基を搭載する場合、水冷技術がほぼ必須となるという。水冷技術を採用した大規模なデータセンターを効率的に構築するには、システムの簡易性が不可欠となる。

こうした課題に対し、AMDはハードウェアのオープンスタンダードの推進によって解決を図っている。データセンター向けハードウェアの効率と革新を加速することを目的としたオープンスタンダードコミュニティ「Open Compute Project」(OCP)に積極的に参加し、OCPの仕様に準拠した製品設計を進めている。また、GPU間の高速接続を可能にする「Ultra Accelerator Link」の普及を促すため、専用のコンソーシアムを主導。さらに、CPUを介さずにGPU間で直接通信を行う「RDMAプロトコル」のオープン化を目指すコンソーシアム「Ultra Ethernet Consortium」の立ち上げにも関与している。大原氏はこれらの取り組みについて「特定の企業に依存しない競争環境を促進することで、ユーザーは複数のベンダーから製品を選択できるようになります。お客さまの選択肢が増えることで、各企業間で価格競争が生まれ、お客さまのTCOの削減にもつながるでしょう」と語る。

次にソフトウェアにおけるオープン性を見ていこう。AMDのGPU向けソフトウェアスタック「AMD ROCm ソフトウェア」は全てオープンソースで提供されており、GitHub上でソースコードが公開されている。そのため誰でもソースコードを閲覧し、改善点の提案や問題の報告を行える。またPyTorchなどの主要なフレームワークでCUDA向けに書かれた既存のスクリプトを変更することなく、AMD Instinct上でそのまま動作させることも可能だ。これにより、移植作業にかかる手間やコストを削減し、開発者の負担軽減にもつなげていくという。

3シリーズのプロセッサーを展開し

AI PCの需要拡大に対応

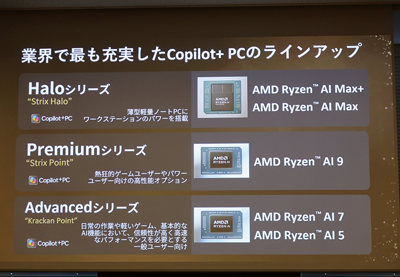

その次に登壇した日本AMD コンシューマ営業部 部長 土子秀人氏は、AI PC向けのソリューションについて紹介した。生成AIの急速な普及や個人データ保護の観点から、ローカルでAI処理を行えるAI PCの重要性が高まっており、AMDはそのニーズに応えるべく、Copilot+ PCに対応した三つのプロセッサーシリーズを展開する。

「昨年から販売を開始した『Halo』および『Premium』シリーズはエンスージアスト向けですが、今年発売した『Advance』シリーズは普及価格帯のCopilot+ PCをサポートしています。これにより、ユーザーの幅広いニーズに応える体制が整いました」(土子氏)

これらCopilot+ PC向けのAMD Ryzen AIシリーズは最新世代の「Zen 5」を採用し、特にマルチタスクに優れた高い処理性能を備えている。またノートPC向けでは最新世代の「Radeonグラフィックス」が組み込まれており、ゲームや動画編集などグラフィック処理の負荷が高い作業にも対応可能だ。さらに最大50TOPSの高いAI処理性能を持つ「XDNA2」を搭載することで、AI関連タスクを高速かつ低消費電力で実行できる。

今後の展望について土子氏は「AI PCは今後加速度的に増え、数年後には、PCの6〜7割を占めると考えています。当社はそれに合わせてポートフォリオを組んでいきます」とAI PC市場の拡大に向けた意欲を語った。

最後に登壇した日本AMD コマーシャル営業本部 セールスエンジニアリング担当マネージャー 関根正人氏は、AIワークステーション向けのソリューションについて紹介した。

AMDは、大型筐体のAIワークステーションに最適な高性能CPU「AMD Ryzen Threadripper PRO 9000」シリーズを提供している。このシリーズは最新のZen 5コアを採用し、最大96コア/192スレッドに対応。前世代の「AMD Threadripper PRO 7995WX」と比べ、マルチスレッド性能が約10%向上している。また大型筐体のAIワークステーションに最適なGPUとして「AMD Radeon AI PRO R9700」を提供している。128基のAIアクセラレーターと32GBのGDDR6 VRAMを搭載し、大規模言語モデルを用いた性能テストでは競合製品の3〜4倍の応答速度を記録したという。

関根氏は「GPUの性能が高くても、ホストとなるCPUの性能が優れていなければシステム全体の性能は十分に引き出せません。こうした考えに基づき当社では、高性能なCPUとGPUを組み合わせることで、高性能なAIワークステーションを提供していきます」と意気込みを語った。

コンシューマ営業部

部長

土子秀人 氏

コマーシャル営業本部

セールスエンジニアリング担当マネージャー

関根正人 氏