生成AI活用に潜むセキュリティリスクと

知っておきたいシステム的対策とは

前回、生成AI活用におけるセキュリティリスク対策として、システム的対策と組織的対策の必要性を説明した。今回は、初めに注意を払うべき生成AI向け利用者のシステム的対策として、情報漏えい対策、アクセス権限の可視化、オーバーシェアリング(過剰共有)対策について説明したい。

安易な生成AI活用に潜むリスク

2022年11月30日にChatGPTが登場してしばらくたつが、皆さんはどのような使い方をしているだろうか。筆者は、ChatGPTのリリース直後は自分がイメージする絵を描いてもらったり、日常で疑問に思ったことに回答してもらったりしていた。適切な回答を得られず、試行錯誤しながらプロンプトを調整した。このような段階を経て、筆者は業務での生成AIの活用を始めた。

最初に行ったのは、長文の要約や情報の検索だが、ここに、生成AI活用の初心者が注意すべきリスクが潜んでいる。生成AIはさまざまな回答を返すが、人間はぜいたくなもので、さらに適切な回答を求めるようになる。業務の経緯や背景をプロンプトに入力すれば、より的確な回答を得られる可能性が高まるのではないかと期待してしまうのだ。

例えば、上長からの指示メールを入力した返信文の生成、雑な議事録を入力して整形された議事録の生成、社内発表資料のシナリオを入力したプレゼンテーション資料の作成といった行為は、いずれも利用する生成AIによっては業務情報の漏えいに当たる。

生成AIサービスへの情報漏えいの抑止

ChatGPTや「Gemini」「Microsoft 365 Copilot」(以下、Copilot)など、さまざまな生成AIサービスが提供されているが、明確な利用のルールを定めている組織は少ないのではないだろうか。まずは、ルールの整備や従業員への教育が必要だが、全従業員に徹底するのは容易ではない。だからこそ、システム的対策が必要になる。その対策例を紹介する。

「Netskope」では、CASB※1機能により生成AIの利用状況の可視化や、ハイリスクな生成AIへのアクセス制御が可能だ。利用アカウントの把握や、DLP※2機能によるアクセス監視と通信内容のチェックも行える。あらかじめ設定したポリシーに基づき、機密情報のアップロードの阻止や、生成AI利用時に警告表示や目的入力を要求するような設定もできる。

また「Menlo Security Web Isolation Service」では、生成AI利用におけるWebブラウザーでのプロンプトの入力時のコピー&ペーストの制限やペースト文字数の制限、操作履歴確認といったことも可能だ。

オーバーシェアリングが生むリスク

ここまでは、インターネット上の生成AIサービス利用時の情報漏えいリスクと対策について説明してきた。ここからは、予期せぬ情報共有(オーバーシェアリング)のリスクについて説明する。社内にCopilotを導入している組織は多いだろう。問題は、Copilotによる検索だ。

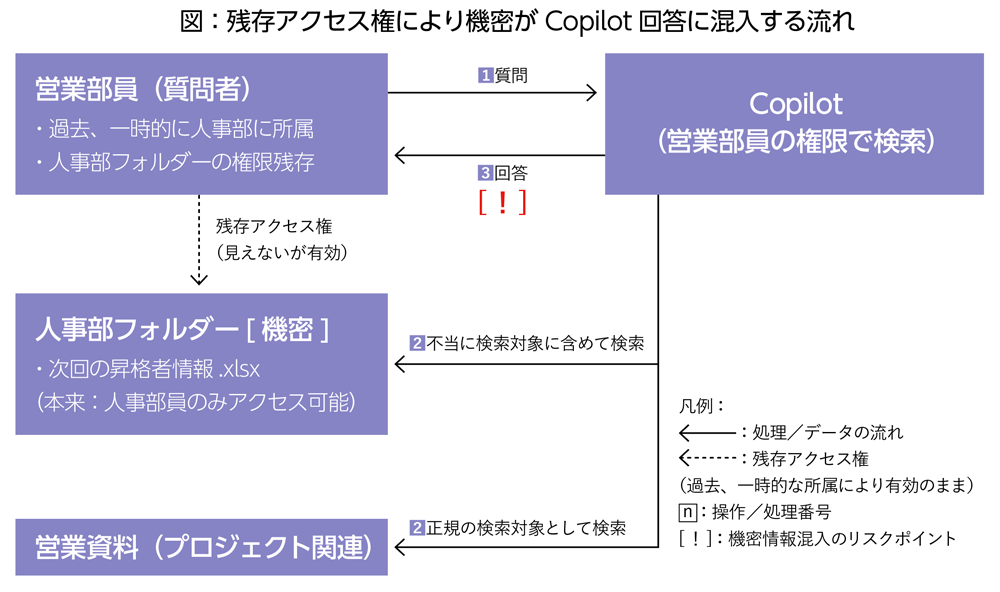

Copilotは、ユーザーがアクセス権を持つドキュメントやメール、チャットなどを参照して回答を生成する。アクセス権には従うが、そもそもその設定が過剰(不適切)な場合がある。部署内の「Microsoft SharePoint」で作成したWebサイトやチームに不要なメンバーまでアクセス権が付与されていると、そのメンバーがCopilotに質問した際、本来アクセスできないはずの情報を含む回答が生成される可能性がある。

例えば、人事部が「次回の昇格者情報」を共有していたフォルダーに、過去一時的に人事部に所属していた営業部員のアクセス権が残っていたとする。その営業部員がCopilotに「プロジェクトの進捗」に関わる内容を尋ねた場合、「次回の昇格者情報」を回答に引用し、共有してしまうリスクがあるのだ(上図)。

このような事態を防ぐには、アクセス権の定期見直しや適切な運用を行う必要があるが、増え続けるドキュメントやフォルダーを厳密に管理するのは容易ではない。この問題に対し、最近では以下のような支援機能を持つ有効なサービスも出てきた。

【支援機能の例】

1.可視化とレポーティング:Microsoft SharePointや「Microsoft Teams」「Microsoft OneDrive」などのアクセス権や共有設定を可視化。これにより、誰がどの機密情報にアクセスできるかを把握し、不適切に設定された共有権限を特定し、是正する。

2.ポリシーベースの自動修復:ポリシーを設定することで、アクセス権の過剰な設定や、非アクティブなユーザーのアクセス権を自動的に削除するなどの修復アクションを実行する。

3.リスク評価とアラート:機密データを含むサイトやドキュメントを特定し、その共有設定がリスクを伴う場合にリアルタイムで通知する。

システム的対策と組織的対策の両立を

ここまで、生成AI利用時のシステム的対策について説明してきた。これらは、生成AIの活用が決まった段階で導入してほしいものであり、利用状況によってまた別の対策も必要となることは知っておいてほしい。また、生成AIサービスの利用においては、セキュリティリスクを意識するだけでは不十分だ。

次回は、従業員に知ってもらうべきそのほかのリスクと、ルール策定や教育などによる対処について説明する。

※1 Cloud Access Security Broker:デバイスとクラウドサービスの間に設置し、利用状況の可視化や利用制御を実施。

※2 Data Loss Prevention:情報漏えいを防止。